ЯНДЕКС —

ДА НАЧНЁТСЯ ВСЁ

им же всё, нахуй, и закончится.

Начало 2000-х

Счастливое, беззаботное время говносайтов с говнотекстами по три ключевика на строчку:

- Купить все проститутки Москва недорого

- Грузоперевозки лучшие Москва

- Шкафы-купе красивые коричневые

Адские ключевые слова нельзя было склонять, спрягать, менять числа, ставить союзы или предлоги между ними. От того, что стояло в ТОП-10 Яндекса, текла кровь из глаз. И всё у всех было заебись! Особенно у SEO-шников

Попасть в ТОП Яндекса в то время было главной и единственной задачей первых ушлых интернет-предпринимателей. А попасть туда было — как нехуй делать.

Просто нужно было, чтобы на всё это дерьмо ссылалось как можно больше другого дерьма. Трастовых сайтов! Делалось это с помощью арендных ссылок. Сайты-новостники, сайты с типа полезной информацией — тоже говносайты, по сути — размещали такие ссылки у себя в подвалах.

Коммерческие сайты с большой ссылочной массой попадали в ТОП Яндекса, на них вешались почты и телефоны. Так люди получали заявки из органики, во всех смыслах этого слова.

Одновременно с SEO-шниками, которым нужна была эта ссылочная масса, как бензин, зарождалась каста вебмастеров (или манимейкеров). Они лепили сайты на информационные тематики и вешали на них чуть более приличные говнотексты. Дорвеи, проще говоря. Т.н. полезный контент древнего мира.

Первое время вебмастера зарабатывали на продаже арендных ссылок. Позже — на продаже статейных ссылок, ну и ещё позже на баннерах.

Формула ранжирования Яндекса была довольно примитивной. И, хоть она держалась в секрете, на первых порах все просто хуячили побольше арендных ссылок, вешали на сайты говнотексты с ключевыми словами — и всё было шоколадно.

Но постепенно ссылок требовалось всё больше, конкуренция в выдаче росла, вокруг размножались как будто митозом дорвеи под эти ссылки… И весь наш Рунет представлял собой прекрасную ёбаную клоаку с сайтами, от которых беременным женщинам становилось дурно.

Автоматизация закупки ссылок

В 2008 году случилась одна хуйня, которая крепко ударила по лбу всей пиздобратии вебмастеров/манимейкеров/SEO-шников. SeoPult автоматизировал продажу ссылок, дав доступ к своей системе любому желающему. Так интернет-предприниматели древнего мира смогли закупать себе ссылочную массу напрямую, минуя посредников в виде SEO-агентств с их наценками. Ну а вебмастера попиздовали в базы биржи, хуле оставалось делать. Они-то в общем своё не потеряли, и довольно долго подъедались заработками на биржах, хотя там типа был строже отбор и проверка сайтов.

Олдфаги сейчас будут бурлить, что первой была биржа Sape, а не SeoPult. Оно действительно так, но Саповцы немного прожевали хуй — и получилось, как с изобретением радио: кто первый громче всех пропиздел, того и тапки.

Помимо Пульта и Сапы нельзя не упомянуть Миралинкс (или просто Мира), но Мира уже больше применялась под покупку/продажу статейных ссылок. Которые выглядели более естественно в глазах поисковых роботов, и их надо было комбинировать с арендными, чтобы оставаться в выдаче.

Война SEO-шников с Яндексом началась с момента его появления. Суперсила первых — хитровыебанность, супероружие второго — обновления алгоритмов ранжирования.

Яндекс выкатывал что-то новое, через месяц-два SEO-шники придумывали, как его наебать. Ослабевали арендные ссылки — стали закупать статейные. Поиск стал более интеллектуальным — ключевые слова стали разбавлять человеческими.

Первое время Яндекс именовал свои обновления по названиям российских городов, после перешёл к созвездиям. С началом космоса «обычные» результаты выдачи стали всё более часто вытесняться внутренними сервисами Яндекса. Вот несколько главных обновлений, которые ёбнули по SEO-шникам большее всего:

Afterparty

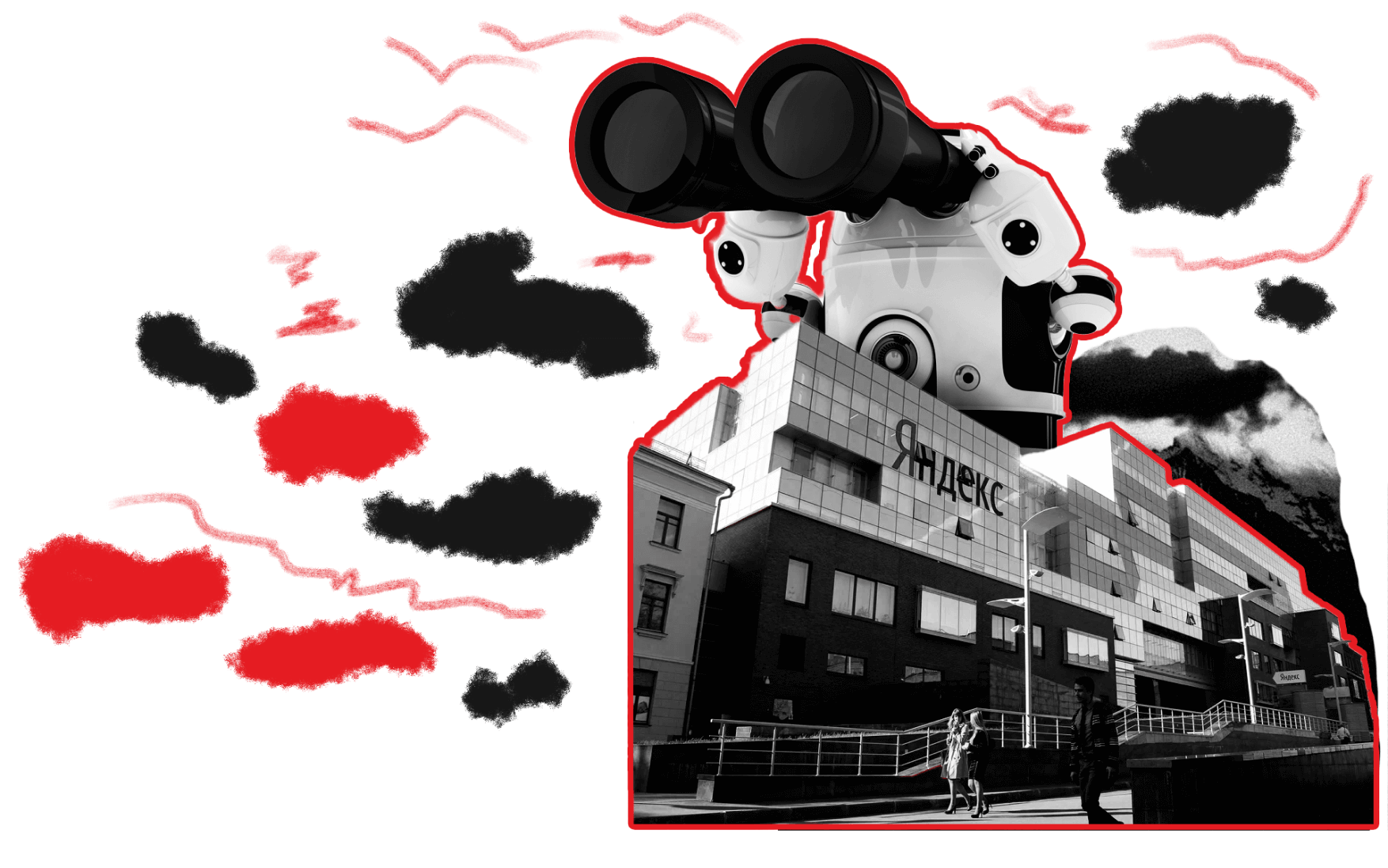

После того как Яндекс свёл до минимума влияние ссылочной массы и текстового спама, понадобились новые факторы ранжирования. Как-то же надо было оставаться поисковой системой, а не просто доской платных объявлений. По мнению Яндекса, хорошей и трендовой альтернативой стали поведенческие факторы. Сюда можно было добавить очень модный и любимый Яндексом ML, нейросети и прочие хайповые истории. Начался век тщательного анализа роботом поведения пользователей на сайтах, чтобы наконец выбрать те, которые лучше всего закрывают поисковые интенты пользователя.

На конференциях Яндекс показывал записи с вебвизора и объяснял, как их новый алгоритм, анализируя поведение пользователя, безошибочно понимает, где настоящий пользователь закрывает свой интент, и грозил очень жёсткими фильтрами тем, кто попробует обойти это с помощью эмуляции или бирж микрозаданий.

Но по факту, под капотом этой истории оказалось несколько параметров, которые удавалось эмулировать как софтом, так и реальными исполнителями. На рынок вышли сервисы Userator и много софтовых предложений по подписке. Эти сервисы могли нагонять сколько угодно якобы живых посетителей, которые имитировали восторг от контента и повышали CTR на выдаче, время на сайте, и снижали общий показатель отказов.

Самое оргазмическое для Яндекса поведение пользователя выглядело (да и сейчас выглядит) очень просто. Пользователь вбил запрос в выдачу, перелез на один сайт, ушёл оттуда, на другой — тоже ушёл, а вот третий ему понравился настолько, что он там походил, вернулся в выдачу и закрыл её, оставшись на найденном сайте. Изобразить такое — как два пальца. Вопрос в итоге свёлся к количеству таких восторженных пользователей. Но и это — как два пальца.

Так как ПФ среди прочих факторов ранжирования имел приоритет, то в ТОП-10 стали залетать абсолютно новые сайты всего за 2-3 недели такой накрутки. В итоге никому не захотелось месяцами вылизывать свои ресурсы, чтобы его обошёл в выдаче ушлый SEO-шник, и использовать ПФ начали практически все, кто хоть как-то занимался продвижением. Если начинался он с крупных конкурентных ниш в Москве, то сейчас даже мелкий региональный е-коммерс использует этот метод. Тем более, когда выдача вордстата ясно даёт понять, что конкуренты его используют тоже.

Вероятно, Яндекс скоро закроет и эту лавочку, тем более что полгода назад в Метрике появился показатель Роботности, который пока не влияет на выдачу, но в один день может превратить все мобильные прокси-фермы и орды ботов в черепки, а манимейкеров снова пересадить за руль Яндекс.Такси.

Внезапный Google

Тем временем в Google была примерно та же ситуация. Сайты точно так же SEO-оптимизировались при помощи дыр в движке. Гугл точно так же выкатывал обновления. В России народ сидел преимущественно в Яндексе, Гуглом в то время пользовались немногие. Но, тем не менее, и у нас существовали SEO-шники под Буржунет, которые весело ходили на хуй с выходом гугловских фильтров типа Panda и Penguin.

Панда вышла 24.02.2011 года в качестве спам-фильтра. Она была нацелена исключительно на контент: искусственно сгенерированные тексты и биржи трафика. На залинкованность ей было насрать. Бесполезные и спам-сайты с низким качеством текстов отсеивались из выдачи.

24.04.2012 появился Пингвин. Он занимался некачественными ссылками. Залинкованные сайты проседали на 10–20 позиций в выдаче, а если их владельцы не принимали никаких мер — и вовсе выносились за ТОП-100.

Гугл красиво нарисуется в истории коммерческого трафика Рунета чуть позже, когда мы заговорим про мобильный трафик.